Digitale Bühnentechnologie von Augmented Reality bis KI-basiertem Kamera-Tracking-System

Digitale Technologien sind seit 2019 wesentlicher Bestandteil unserer Theaterarbeit. Dabei sehen wir uns gerade in den Bereichen Augmented Reality und Künstliche Intelligenz durchaus in einer Vorreiterrolle – eine Kompetenz, die wir auch in Zukunft kontinuierlich vertiefen und ausbauen wollen und deart für Berlin auch künftig als international sichtbares Labor für Musik und Tanztheater an der Zukunft mitzuarbeiten.

„Angefangen haben wir 2019 zum Bauhaus-Jubiläum, als wir dazu aufgefordert wurden, einmal mit der avanciertesten Technologie im Theater zu arbeiten. Damals haben wir abstrakte Formen und historische Bilder visualisiert und im ,,Verrat der Bilder“ mit Performer:innen in Beziehung gesetzt. So sind wir erst mal mit dieser Technologie in Berührung gekommen, auf der nun die AR-Loop-Maschine basiert. Uns wurde aber auch bald klar, dass der reale Mensch nicht hinter der Technik verschwinden darf, woraus sich dann die jetzt vorgestellte Form entwickelt hat. Ein wichtiger Teil des Prozesses war eben die Möglichkeit, Bewegungsdaten mit den Motion-Capture-Anzügen zu integrieren, wofür uns besonders der Corona-Stillstand Entwicklungs-Zeit gelassen hat. Das bislang unverzichtbare Instrument bei solchen Inszenierungen aber bleibt die AR-Brille. Alle anderen Projektionen im Raum, die oft fälschlicherweise als Hologramme bezeichnet werden, basieren auf zweidimensionalen Tricks (,,Pepper’s ghost“ von 1862). Aus Dokumentationen solcher Illusionen entstehen Erwartungshaltungen, die in der Realität technisch jedoch nicht eingelöst werden können oder eben nur mit der Brillentechnik.“ [Oliver Proske im Gespräch mit Thomas Irmer | Theater der Zeit 9/2022]

Seit 2022 arbeiten wir gemeinsam mit Prof. Dr.-Ing. Steffen Borchers Tigasson (HTW Berlin) an der Entwicklung eines KI-basierten Kamera-Tracking-Systems. Ziel ist es, dass sich künftig nicht mehr die Performer*innen nach der Technik richten müssen, sondern sich die Technik intelligent und flexibel an ihre Bewegungen anpasst. Dadurch sollen neue künstlerische Ausdrucksmöglichkeiten auf der Bühne erschlossen und langfristig Arbeitsprozesse effizienter gestaltet werden. Im Verlauf der Kooperation haben wir bereits einen eigenen Trilaterationsalgorithmus entwickelt, der speziell auf die Anforderungen unseres Theaterbetriebs zugeschnitten ist. Durch die gezielte Analyse theoretischer Fehler ermöglicht dieser eine deutlich höhere Positionsgenauigkeit. In einer weiteren Projektphase geht es darum, das KI-basierte Kamera-Tracking-System mit einem Decawave gestützten Ortungssystem zu kombinieren und eine Sensorfusion auf KI-Basis zu realisieren. Dies soll einen bedeutenden Technologiesprung ermöglichen und das seit Langem angestrebte Ziel der präzisen, automatisierten Performer-Tracking-Lösung auf der Bühne realisieren.

Die Kamera bleibt automatisch dran

[Campus Stories Online Magazin der HTW Berlin | Gisela Hüttinger | 2023]

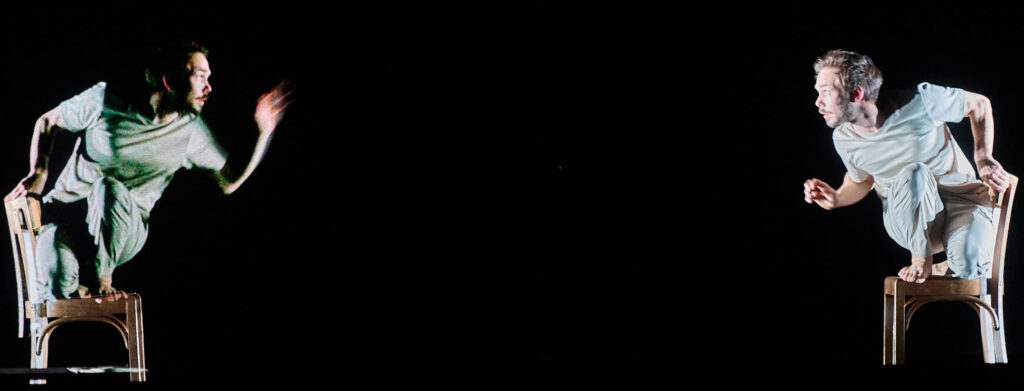

Die Menschen auf der Bühne bewegen sich schnell, machen Sprünge, verschwinden, kehren wieder zurück. Ihre Mimik und so manche Geste blieben verborgen, wären da nicht bewegte Nahaufnahmen von Gesichtern und Körpern auf der Leinwand hinter der Bühne. So kann auch das Publikum in der allerletzten Reihe Wut erkennen, Resignation oder Hoffnung. Keine Seltenheit bei der Berliner Kompagnie ‚Nico and the Navigators‘. Die mit vielen Auszeichnungen bedachte Truppe ist bekannt dafür, dass sie digitale Komponenten in ihre Aufführungen integriert. Weil sie ihre künstlerische Sprache weiterentwickeln möchte, hat sie Prof. Dr.-Ing. Steffen Borchers-Tigasson aus dem Studiengang Elektrotechnik der HTW Berlin um Unterstützung gebeten. Der Experte für Automation und Künstliche Intelligenz (KI) entwickelt nun die Kameratechnologie auf der Basis von KI weiter.

„Technologisch erst seit wenigen Jahren realisierbar“

Als die Anfrage kam, zögerte Prof. Dr.-Ing. Borchers-Tigasson keine Sekunde. Er hatte bereits privat Aufführungen von ‚Nico and the Navigators‘ besucht, auch solche mit Videoprojektionen. „Die Kompagnie ist ungeheuer technikaffin“, sagt er. Der Auftrag, ein automatisches, auf KI basierendes Kameratracking zu entwickeln, interessierte ihn sofort. „Technologisch ist das erst seit wenigen Jahren realisierbar“, sagt der Wissenschaftler. Gleichzeitig mache es ihm große Freude, Künstler*innen ein neues Werkzeug in die Hand zu geben und dadurch neue Möglichkeiten zu eröffnen.

Mehr Freiraum für Tänzer*innen und Schauspieler*innen

Den Tänzer*innen und Schauspieler*innen auf der Bühne mehr Freiraum zu verschaffen, war exakt das Motiv von Auftraggeber Oliver Proske. Er hat ‚Nico and the Navigators‘ mit Nicola Hümpel vor 25 Jahren gegründet. Als Produzent und Geschäftsführer zeichnet der studierte Industriedesigner und Bühnenbildner bei vielen Produktionen verantwortlich für die Digitale Bühne, das Konzept und die passende Technologie. Diese Technologie ist ihm zu statisch geworden. „Sie schränkt die Künstler*innen ein“, findet er. Denn die Kameras müssen auf die Sekunde genau voreingestellt und sämtliche Mitwirkende exakt an fest definierten Punkten auf der Bühne sein, damit projektionsfähige Nahaufnahmen überhaupt möglich werden. „Um flexibler zu werden, haben wir lange selbst mit einem Sensorsystem experimentiert“, erzählt Proske. Doch mit den ästhetischen Resultaten sei man so unzufrieden gewesen, dass man Expertise gesucht habe.

Gefragt ist ein intelligentes System

Gewünscht wird ein intelligentes Kamerasystem, das Künstler*innen auf der Bühne automatisiert, aber völlig flexibel folgt, egal wie schnell die Bewegungen sind, und dabei Bilder erzeugt, die quasi in Echtzeit von der Kameraregie für die Projektionen ausgewählt werden können. „Die technischen Anforderungen sind hoch“, räumt Prof. Dr.-Ing. Borchers-Tigasson ein.

Menschen erkennen und ihnen folgen

Die Kamera muss erstens beweglich und in der Lage sein, selbstständig heran- und weg zu zoomen. Zweitens darf sie nicht nur Bilddaten in Gestalt von Pixeln übertragen. Sie muss vielmehr Menschen erkennen, ihnen zuverlässig folgen und sie im Zweifelsfall auch wieder aufspüren, wenn sie die Bühne kurz verlassen und später wiederkehren, was ja in Tanz und Theater regelmäßig passiert. Und wenn zwei Kameras auf ein und dieselbe Szene gerichtet sind, muss das System unterscheiden, wo ein und dieselbe Person agiert. Dem menschlichen Auge bzw. Gehirn fällt das leicht dank Haarfarbe, Körpergröße oder anderen Merkmalen. Die Kamera hat es ungleich schwerer. Sie muss eine Art Gesichtserkennung betreiben. „Genau an diesem Punkt kommt die künstliche Intelligenz ins Spiel“, sagt Prof. Dr.-Ing. Borchers-Tigasson.

„Eine Roboterkamera will aber niemand“

Stellt sich die Frage, ob ein so intelligentes System mittelfristig den Menschen hinter der Kamera überflüssig macht. Ganz im Gegenteil, sind alle Beteiligten überzeugt. „Eine Roboterkamera will niemand“, sagt Oliver Proske. Mit der Technologie würden vielmehr völlig neue künstlerische Ausdrucksformen entstehen. Genau daran haben ‚Nico and the Navigators‘ Interesse.

Künstlerisch anspruchsvolle Kameraregie

Folgendermaßen muss man sich das Szenario vorstellen, bei dem die neue Technologie zum Einsatz kommt: Während der Aufführung gehen bei der Kamerafrau Echtzeitbilder der im Raum positionierten Kameras ein. Deren Einstellungen kann sie mit einem sogenannten ‚Interface‘, also einer Schnittstelle, live verändern. Die Kamerafrau entscheidet dann, welche Schauspieler*innen in den Fokus genommen werden, ob die jeweilige Kamera näher rangeht, aus welchem Blickwinkel gefilmt wird und welche Bilder hinter der Bühne gezeigt werden. „Das ist ein kreativer und anspruchsvoller Prozess, der höhere Anforderungen stellt und gleichzeitig mehr künstlerischen Freiraum gibt“, findet Prof. Dr.-Ing. Borchers-Tigasson und spricht von „Kameraregie“.

Auch Studierende der Elektrotechnik waren beteiligt

Schritt für Schritt hat der Wissenschaftler das intelligente Kamerasystem in Zusammenarbeit mit der Kompagnie entwickelt. Auch Studierende der Elektrotechnik waren in der ersten Phase mit Abschlussarbeiten und Projektarbeiten beteiligt. „Studentisches Interesse zu wecken, war überhaupt nicht schwer“, freut sich der Hochschullehrer. Im Herbst hat er die Kompagnie in die Probenräume begleitet und die Technik an die dortige Umgebung und die Handlung angepasst.

Praxistest im Dezember im Berliner Radialsystem

Im Dezember 2023 wird das intelligente Kamerasystem bei der Wiederaufnahme des Stücks ‚sweet surrogates‘ zum ersten Mal in realer Umgebung getestet. Falls alles gut läuft, wird es auch für die Aufführung im Berliner Radialsystem genutzt, wo ‚Nico and the Navigators‘ regelmäßig auftreten. Prof. Dr.-Ing. Borchers-Tigasson wird natürlich nicht im Publikum sitzen, sondern backstage anzutreffen sein, Lampenfieber inklusive.

Vom ersten Erleben her würde ich sagen, das ist tatsächlich eine Sache, die im Theater zukunftsträchtig sein kann. Wie sehen die Perspektiven aus?

Mit Walter Benjamin zu sprechen: Eine Aufgabe von Kunst ist es, eine Nachfrage zu erzeugen, für deren volle Befriedigung die Zeit noch nicht gekommen ist. Als Künstler können wir ja nur unsere Arbeit vorstellen, deren Wirkung müssen die Zuschauer und Kritiker bewerten. Wie gesagt, bei „Leben rendern“ handelt es sich um das inhaltlich adäquate Ausprobieren von technologischen Möglichkeiten.

Oliver Proske von NICO AND THE NAVIGATORS im Gespräch mit Thomas Irmer

Nachdem in der Juni-Ausgabe im ersten Teil des Schwerpunkts Jonas Zipfs Essay das gesamte Betriebssystem Theater in den Blick nahm, geht es auf den folgenden Seiten um neue technologische Anwendungen: Die virtuelle Erweiterung des Bühnenraums, ein Austausch über die Zukunft der Theaterkritik und erstmalig der Abdruck eines Stücktextes, der von einer KI geschrieben wurde.

Mit der von euch entwickelten Software erlebt man einen hybriden Raum, in dem sich künstliche Elemente mit einer realen Performance verbinden. Das Prinzip basiert auf den schon öfter auch im Theater eingesetzten Augmented-Reality-Brillen, erweitert aber das Spektrum. Um was handelt es sich genau?

Man könnte sagen, dass wir eine immaterielle Traumlandschaft erzeugen, in der sich bereits Geschehenes mit aktuellen Ereignissen überlagert: Reale Performer:innen werden dabei mit imaginären Bildern konfrontiert, was künftig sicher neue Möglichkeiten des Erzählens eröffnet - als Fortschreibung der Virtual Reality, bei der bislang ja vor allem eine filmische Illusion erzeugt wird. Bei der von uns verwendeten Technik wird daraus eine Live-Raum-Begegnung von tatsächlich vorhandenen Körpern mit bewegten virtuellen Elementen, die in ihrer Dreidimensionalität bislang nur in der Fantasie vorgestellt werden konnten.

Konkret sind es ja eine Art Gliederpuppen, die sich zusammen mit den realen Tänzern in eurer Produktion "Du musst Dein Leben rendern!" bewegen.

Diese animierten Figuren sind zunächst von den beiden Darsteller:innen selbst mit ihren Bewegungen belebt worden, die durch Datenanzüge abgenommen wurden. Die Tänzerin und der Tänzer stehen also mit ihren eigenen Abbildern im Dialog, was aber nur das Publikum mit der Brille so wahrnimmt. Im Probenprozess müssen die Akteure daher die genau zu ihrem Gegenüber passenden Bewegungen einstudieren - synchronisiert wird die Choreografie ganz klassisch über die Musik. Wir haben dabei die Möglichkeit, die Figurinen in jeder beliebigen Größe und Anzahl erscheinen zu lassen, also in verschiedenster Form - und so die Harmonie wie den Konflikt zwischen Schöpfer und Geschöpf zu zeigen. Das weckt natürlich eine Fülle von Assoziationen - von der Genesis über Pygmalion und Frankenstein bis zu aktuellen Debatten zu Chancen und Risiken der Künstlichen Intelligenz.

Wer gestaltet das?

Bei NICO AND THE NAVIGATORS arbeitet seit Jahren die Tänzerin und Choreografin Yui Kawaguchi, die inzwischen auch die digitalen Medien als Erweiterung ihres kreativen Ausdrucks entdeckt hat. Sie hat das mit den beiden Tänzer:innen entwickelt, ihre Bewegungen aufgezeichnet und den Probenprozess geleitet. Nicola Hümpel kam als Regisseurin beratend hinzu. Technisch muss man wissen, dass wir die Software unabhängig von der nun damit gestalteten Choreografie entwickelt haben, was die Sache einerseits noch viel komplizierter macht. Andererseits aber entsteht so eine Technik mit offenen Möglichkeiten, die intuitiv genutzt werden kann - das System soll künftig auch für weitere, ganz anders gedachte Projekte eingesetzt werden.

Es ist also kein Zufall, dass ihr mit Tanz angefangen habt, also kein textbasiertes Schauspieltheater dafür entwickelt.

Angefangen haben wir 2019 zum Bauhaus-Jubiläum, als wir dazu aufgefordert wurden, einmal mit der avanciertesten Technologie im Theater zu arbeiten. Damals haben wir abstrakte Formen und historische Bilder visualisiert und im ,,Verrat der Bilder" mit Performer:innen in Beziehung gesetzt. So sind wir erst mal mit dieser Technologie in Berührung gekommen, auf der nun die AR-Loop-Maschine basiert. Uns wurde aber auch bald klar, dass der reale Mensch nicht hinter der Technik verschwinden darf, woraus sich dann die jetzt vorgestellte Form entwickelt hat.

Ein wichtiger Teil des Prozesses war eben die Möglichkeit, Bewegungsdaten mit den Motion-Capture-Anzügen zu integrieren, wofür uns besonders der Corona-Stillstand Entwicklungs-Zeit gelassen hat. Das bislang unverzichtbare Instrument bei solchen Inszenierungen aber bleibt die AR-Brille.

Alle anderen Projektionen im Raum, die oft fälschlicherweise als Hologramme bezeichnet werden, basieren auf zweidimensionalen Tricks (,,Pepper's ghost" von 1862). Aus Dokumentationen solcher Illusionen entstehen Erwartungshaltungen, die in der Realität technisch jedoch nicht eingelöst werden können oder eben nur mit der Brillentechnik.

Vom ersten Erleben her würde ich sagen, das ist tatsächlich eine Sache, die im Theater zukunftsträchtig sein kann. Wie sehen die Perspektiven aus?

Mit Walter Benjamin zu sprechen: Eine Aufgabe von Kunst ist es, eine Nachfrage zu erzeugen, für deren volle Befriedigung die Zeit noch nicht gekommen ist. Als Künstler können wir ja nur unsere Arbeit vorstellen, deren Wirkung müssen die Zuschauer und Kritiker bewerten. Wie gesagt, bei „Leben rendern" handelt es sich um das inhaltlich adäquate Ausprobieren von technologischen Möglichkeiten. Das nächste Projekt von NICO AND THE NAVIGATORS ist übrigens wieder komplett analog: ,,Fleisch und Geist".//

„Du musst Dein Leben rendern!" vom 14. bis zum 18. September 2022 im Dock Art Berlin: www.navigators.de/projects/du-musst-dein-leben-rendern/

Workshop mit der AR-Loop-Maschine vom 4. bis zum 8. November 2022 in Dresden: www.labore-fuer-digitale-szenografie.de/veranstaltungen/labor-5/

Tickets für diesen Termin sind noch nicht erhältlich. Hinterlassen Sie Ihre E-Mail-Adresse, um benachrichtigt zu werden, wenn Tickets verfügbar sind.